Supercomputación y computación cuántica en ciberseguridad

Los ordenadores que impulsaron misiones espaciales como las sondas Voyager en 1977 representaban la cúspide tecnológica de su época, operando con apenas unos kilobytes de memoria y frecuencias de reloj de unos cientos de kilohertzios. Cuatro décadas más tarde, cualquier teléfono móvil comercial posee millones de veces más potencia de procesamiento, integrando capacidades que habrían sido impensables en aquel entonces.

Hoy, la vanguardia de la computación se manifiesta en sistemas de supercomputación compuestos por cientos de miles de núcleos y redes de procesamiento en paralelo capaces de ejecutar cuatrillones de operaciones por segundo que se emplean en campos tan diversos como la predicción climática, la modelización de pandemias, la investigación en física de partículas o el desarrollo de inteligencia artificial. Sin embargo, este crecimiento también ha revelado una limitación clave: muchos problemas de interés científico e industrial presentan un coste computacional exponencial, lo que significa que su resolución práctica queda fuera del alcance incluso de los superordenadores más potentes.

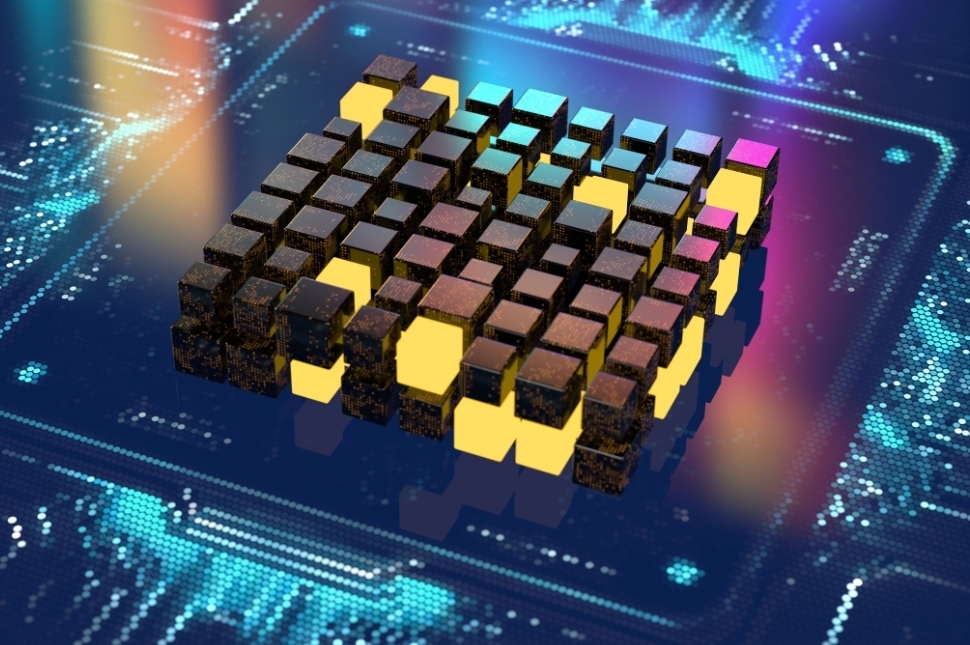

Es aquí donde emerge desde hace algunos años la computación cuántica, no como una mejora incremental, sino como una auténtica ruptura de paradigma. A diferencia de los bits clásicos, que solo pueden representar un 0 o un 1 en un momento dado, los qubits —la unidad fundamental de la computación cuántica— pueden estar en una superposición de estados, lo que les permite representar simultáneamente combinaciones de 0 y 1. Además, gracias al fenómeno del entrelazamiento cuántico, los qubits pueden correlacionarse entre sí de forma que el estado de uno dependa instantáneamente del estado del otro, incluso a distancia. En lugar de recorrer secuencialmente todos los caminos posibles como un ordenador clásico, el ordenador cuántico actúa sobre un espacio de soluciones mucho mayor en una fracción del tiempo, lo que le otorga ventajas excepcionales en ciertos tipos de problemas como la simulación de sistemas moleculares o la optimización combinatoria.

En el ámbito de la ciberseguridad, la computación cuántica representa una amenaza directa a los sistemas criptográficos tradicionales, cuya seguridad se basa en problemas matemáticos que un ordenador cuántico suficientemente avanzado podría resolver con relativa facilidad. Este punto de inflexión se conoce como el “Q-Day”: el día en que una computadora cuántica operativa y escalable sea capaz de romper los algoritmos criptográficos ampliamente utilizados en la actualidad, comprometiendo la confidencialidad de comunicaciones seguras, datos financieros, archivos sensibles e incluso la integridad de infraestructuras críticas a nivel global.

El estado actual de la tecnología cuántica se sitúa como una amenaza plausible pero todavía no materializada para la criptografía, es decir, que no hay evidencias de que exista a día de hoy un ordenador cuántico capaz de romper los esquemas públicos más usados. La Comisión Europea publicó en junio de 2025 una hoja de ruta de implementación coordinada para la transición a la criptografía post-cuántica en la que sitúa la llegada de un “ordenador cuántico criptográficamente relevante” en un máximo de 16 años (≈2040), con la posibilidad de acortar el horizonte a 10 años si se verifican plenamente las heurísticas de corrección/mitigación de errores y progresa el hardware; además, recoge estimaciones de expertos que asignan un 19–34 % de probabilidad de romper RSA-2048 en 24h dentro de la próxima década.

¿Qué frena proyectos de mayor capacidad y más qubits? Primero, la calidad de las operaciones: tal como se refleja en la hoja de ruta europea en la que ha participado INCIBE, el “cuándo” depende de verificar las heurísticas de corrección/mitigación y de que el hardware siga mejorando. Segundo, la escalabilidad: escalar manteniendo fidelidad sigue siendo el gran reto. En resumen: menos errores y más integración son la vía, pero todavía no hay una fecha cierta en la que la capacidad sea suficiente para comprometer los sistemas criptográficos vigentes.

Factores de riesgo e impacto

En este contexto de transformación tecnológica, convergen varios factores de riesgo significativos para la seguridad de la información.

Algoritmos vulnerables: Los algoritmos criptográficos más usados actualmente —como RSA, ECC o Diffie-Hellman en criptografía asimétrica o de clave pública— están diseñados sobre la base de problemas matemáticos como la factorización de enteros grandes o el logaritmo discreto de curva elíptica, que resultan sencillos de calcular en un sentido, pero muy complejos en sentido inverso. Sin embargo, con el desarrollo de ordenadores cuánticos suficientemente potentes, se podría hacer uso de algoritmos como el de Shor para resolver estos problemas matemáticos en tiempos razonables, comprometiendo la seguridad de estos sistemas criptografícos tradicionales. El superordenador japonés Fugaku, desarrollado conjuntamente por RIKEN y Fujitsu, es uno de los sistemas más potentes del mundo, con un rendimiento máximo de 442 petaflops (442 cuatrillones de operaciones por segundo). A pesar de esta inmensa capacidad, resolver la factorización de un número RSA de 2048 bits usando métodos clásicos sería inviable, ya que el coste computacional escala exponencialmente y podría tardar miles de años. En contraste, Fujitsu ha utilizado su simulador cuántico de 39 qubits, apoyado en la potencia de cálculo del Fugaku y tecnologías de computación paralela, para evaluar la vulnerabilidad del RSA-2048 frente a ataques con ordenadores cuánticos ejecutando el algoritmo de Shor. Sus estudios indican que un ordenador cuántico con alrededor de 10,000 qubits lógicos y 2.23 trillones de operaciones cuánticas requeriría aproximadamente 104 días de cómputo tolerante a fallos para factorizar una clave RSA de 2048 bits. Aunque esta cifra está muy lejos de las capacidades actuales, demuestra el potencial disruptivo de la computación cuántica.

Ventana de exposición para captura de datos cifrados: Una amenaza actual significativa es la estrategia conocida como “harvest now, decrypt later” (capturar ahora, descifrar después). Los atacantes han empezado a almacenar grandes volúmenes de datos cifrados en la actualidad de información altamente sensible y no perecedera, aunque no tengan la capacidad inmediata para descifrarlos. Sin embargo, cuando los ordenadores cuánticos suficientemente potentes estén disponibles y de uso generalizado, estos datos almacenados podrían ser descifrados, exponiendo información sensible y confidencial. Este riesgo es especialmente crítico para datos con valor a largo plazo, como secretos industriales, información gubernamental, registros médicos, genómicos, biométricos y datos personales. Por ejemplo, documentos clasificados interceptados hoy podrían ser revelados en el futuro, comprometiendo la seguridad nacional y la privacidad de individuos.

Diagrama sobre harvest now, decrypt later

La comunicad científica, impulsada por el NIST americano y también iniciativas europeas, ha conseguido crear y testar diferentes algoritmos software resistentes a ataques cuánticos “o quantum-safe”. Tras varios procesos de selección ya hay algoritmos finalistas para las principales primitivas criptográficas como los basados en retículos, como ML-KEM (CRYSTALS-Kyber) para el intercambio de claves y ML-DSA (CRYSTALS-Dilithium) y FALCON para firmas digitales. Estos algoritmos finalistas vienen con documentación suficiente para que puedan ser implementados por la industria en infraestructuras tecnológicas (hardware, firmware, SO, APIs, librerías, aplicaciones, servicios, arquitecturas...). Se sigue trabajando para probar estos algoritmos y crear y probar nuevos para aumentar dicho listado y ofrecer más opciones a la industria, así como para crear versiones ligeras para entornos de pocas capacidades (cómputo o memoria) como sistemas empotrados, etc. Por tanto, la comunidad científica ya ha hecho su parte, ahora es el turno de gobiernos e industria para realizar la migración.

A pesar de las grandes incertidumbres que aún rodean a la computación cuántica y su impacto en la seguridad, comienzan a surgir los primeros avances post-cuánticos en criptografía, con algoritmos que buscan proteger la confidencialidad, la integridad y el intercambio seguro de claves frente a la amenaza de los ordenadores cuánticos. Por ejemplo, para el intercambio seguro de claves y cifrado, destacan Kyber, basado en criptografía de redes, y HQC (en estado de estandarización por el NIST), que utiliza códigos correctores de errores como alternativa robusta. En el ámbito de la autenticación e integridad de datos, Dilithium ofrece firmas digitales resistentes a ataques cuánticos, también basado en criptografía de redes.

Dificultad de transición a nuevos sistemas criptográficos: La adopción de algoritmos criptográficos resistentes a la computación cuántica representa un desafío importante. Muchos sistemas actuales, incluidos dispositivos embebidos y grandes infraestructuras, dependen de arquitecturas y protocolos diseñados para algoritmos clásicos. Cambiar estos sistemas implica un esfuerzo técnico considerable, debido a requerimientos diferentes de capacidad de procesamiento, tamaño de claves y compatibilidad. Esta dificultad puede retrasar la implementación de medidas de protección adecuadas, dejando expuestas muchas organizaciones y sistemas durante un tiempo prolongado. Por ejemplo, sistemas de control industrial antiguos o dispositivos IoT con recursos limitados podrían no ser capaces de soportar la criptografía post-cuántica sin actualizaciones costosas o incluso reemplazos completos. Adicionalmente hay que orquestar esta migración para que ambos extremos de una comunicación adquieran estas capacidades sin dejar de poder comunicarse constantemente.

Estos factores de riesgo pueden acarrear impactos significativos en diversas dimensiones clave de la seguridad de la información, socavando directa o indirectamente la confidencialidad, integridad y disponibilidad de informaciones y sistemas; poniendo en jaque la confianza en los sistemas digitales tal y como los concebimos a día de hoy.

Medidas de protección y mejores prácticas

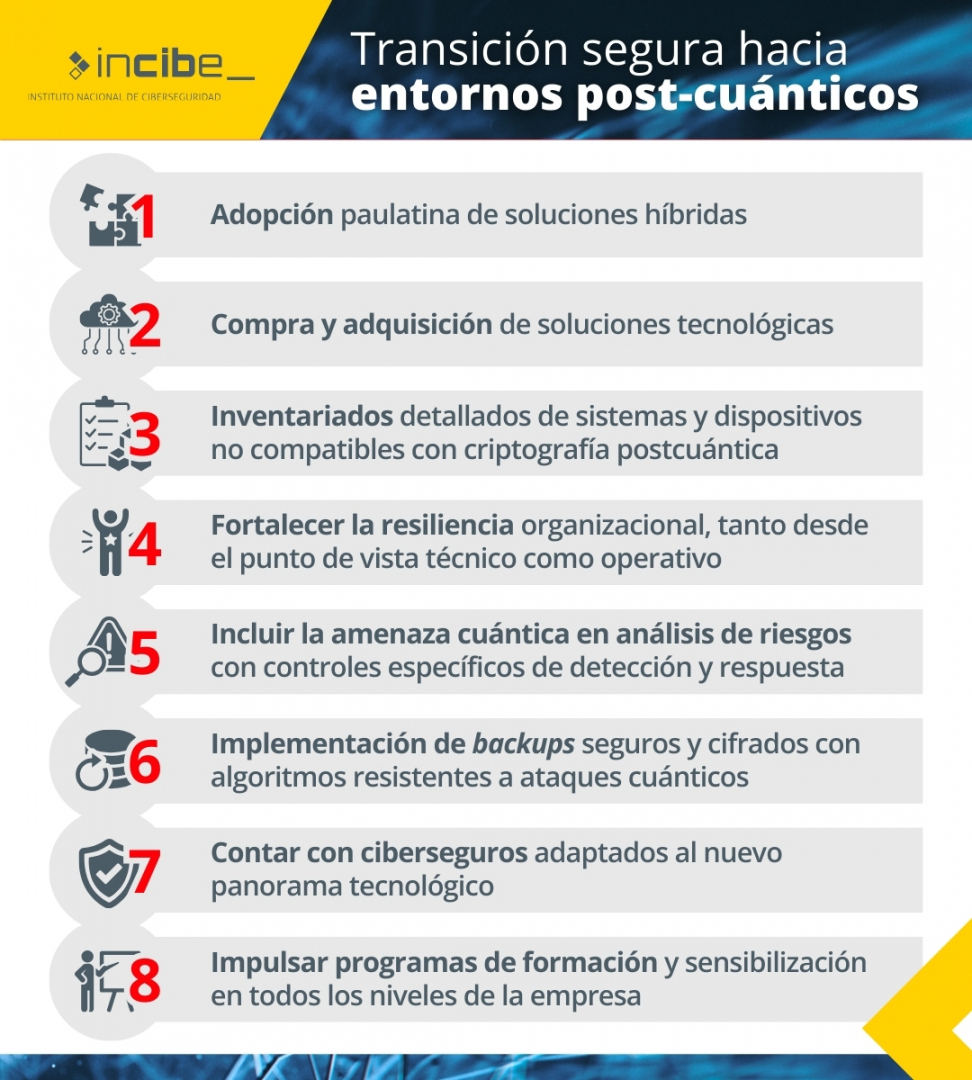

Para acompañar estos desarrollos tecnológicos, es crucial implementar medidas de protección y mejores prácticas que garanticen una transición segura hacia entornos post-cuánticos.

Una estrategia recomendada es la adopción paulatina de soluciones híbridas (cripto agilidad) que combinen algoritmos clásicos y post-cuánticos, como integrar PQXDH — un protocolo de intercambio de claves post-cuántico que extiende el conocido protocolo XDH (empleado en aplicaciones de mensajería segura como Signal) — junto a métodos tradicionales en el intercambio de claves, permitiendo una defensa gradual sin comprometer la interoperabilidad actual. Los Estados miembros de la UE, publicaron en junio de 2025 una hoja de ruta de implementación coordinada para la transición a la criptografía post-cuántica.

Incluir en los procesos de compra y adquisición de soluciones tecnológicas, requisitos específicos de características y capacidades criptográficas, alineadas con criptografía postcuántica.

Además, se deben elaborar inventarios detallados de sistemas y dispositivos que no sean compatibles con la criptografía postcuántica y establecer planes de actualización progresiva en función de la criticidad de la información que gestionan, que establezcan plazos realistas alineados con la capacidad cuántica acutal y el Q-Day

Fortalecer la resiliencia organizacional, tanto desde el punto de vista técnico como operativo, será clave para sostener la continuidad del negocio: las organizaciones también deben incluir la amenza cuántica en su análisis de riesgos, así como definir controles específicos para la detección y respuesta frente a esta amenaza, con líneas de acción claras ante posibles impactos. La implementación de backups seguros y cifrados con algoritmos resistentes a ataques cuánticos también ayudará la recuperación de datos críticos en escenarios adversos de criptografía comprometida.

En paralelo, contar con ciberseguros adaptados al nuevo panorama tecnológico puede ofrecer una capa adicional de respaldo financiero frente a incidentes imprevistos.

Finalmente, impulsar programas de formación y sensibilización en todos los niveles de la empresa permitirá que el personal comprenda los riesgos y adopte buenas prácticas frente a los desafíos de la era cuántica.

Conclusión

El riesgo cuántico no es una posibilidad remota, sino una amenaza real que exige una respuesta proactiva y coordinada. Según una encuesta de la ANSSI en marzo de 2025 a operadores de infraestructuras críticas en Francia, más de la mitad de las organizaciones se encuentran actualmente expuestas a esta amenaza. Esto se debe, por ejemplo, al uso de VPNs que emplean certificados digitales para transmitir información sensible cuya confidencialidad debe mantenerse durante más de diez años. Aunque muchas entidades reconocen teóricamente la amenaza cuántica, el impacto real sobre sus propios sistemas suele ser desconocido, y son pocas las que han iniciado análisis de riesgos específicos o planes de transición hacia algoritmos postcuánticos. Entre los principales obstáculos destacan la complejidad técnica de integración en entornos heredados, la falta de estándares consolidados, la inmadurez de las soluciones disponibles y las limitaciones en recursos humanos y financieros.

Frente a este panorama, es crucial iniciar desde ahora la transición y fomentar una cooperación sólida entre los sectores público y privado para prevenir una crisis de ciberseguridad de alcance global.

El problema es conocido, la amenaza es real, el diseño de soluciones con nuevos algoritmos PQC ya está disponible. El reto actual es por tanto la transición o implementación de criptografía clásica a postcuántica y recae principalmente en gobiernos, industria y empresas. La transición requiere planificar y ejecutar sin demora de forma coordinada la migración a soluciones resistentes a ataques cuánticos. Cuando los fundamentos del ciber-espacio y por tanto de la Sociedad de la información están en juego, el esfuerzo bien merece la pena.